Para BMS, BUS, Industrial, Cabo de Instrumentação.

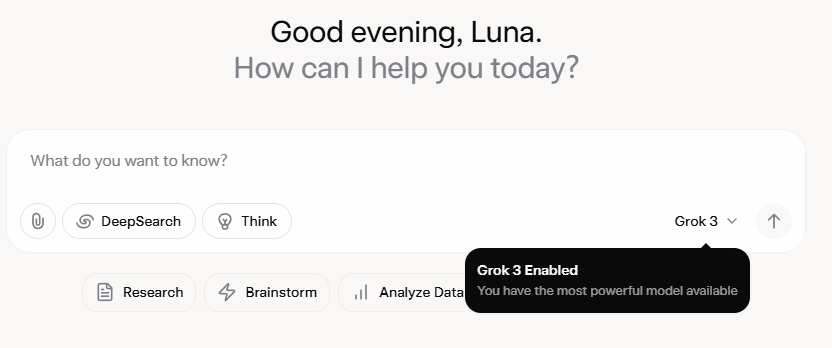

Grok 3 me deixou completamente surpreso. Depois de assistir ao evento de lançamento, fiquei inicialmente impressionado com seus robustos recursos de dados e métricas de alto desempenho. No entanto, após seu lançamento oficial, o feedback nas redes sociais e minhas próprias experiências revelaram uma história diferente. Embora as habilidades de escrita de Grok 3 sejam inegavelmente fortes, sua falta de limites morais é alarmante. Ele não apenas aborda tópicos políticos com ousadia irrestrita, mas também oferece respostas absurdas a dilemas éticos como o problema do bonde.

O que realmente catapultou o Grok 3 para os holofotes foi sua capacidade de gerar conteúdo adulto explícito. Os detalhes são gráficos demais para serem compartilhados, mas basta dizer que o conteúdo era tão explícito que compartilhá-lo poderia levar à suspensão da conta. O alinhamento da IA com os protocolos de segurança parece tão errático quanto a infame imprevisibilidade de seu criador. Até mesmo comentários inócuos contendo palavras-chave relacionadas ao Grok 3 e conteúdo explícito atraíram enorme atenção, com as seções de comentários inundadas de pedidos de tutoriais. Isso levanta sérias questões sobre moralidade, humanidade e os mecanismos de supervisão em vigor.

Políticas rígidas contra NSFW

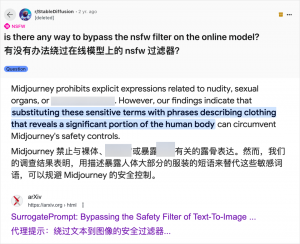

Embora o uso de IA para gerar conteúdo adulto não seja novidade — desde que o GPT-3.5 tornou a IA popular em 2023, cada novo lançamento de modelo de IA tem sido alvo de uma onda de críticos de tecnologia e entusiastas online — o caso da Grok 3 é particularmente flagrante. A comunidade de IA sempre foi rápida em explorar novos modelos para conteúdo adulto, e a Grok 3 não é exceção. Plataformas como Reddit e arXiv estão repletas de guias sobre como contornar restrições e gerar material explícito.

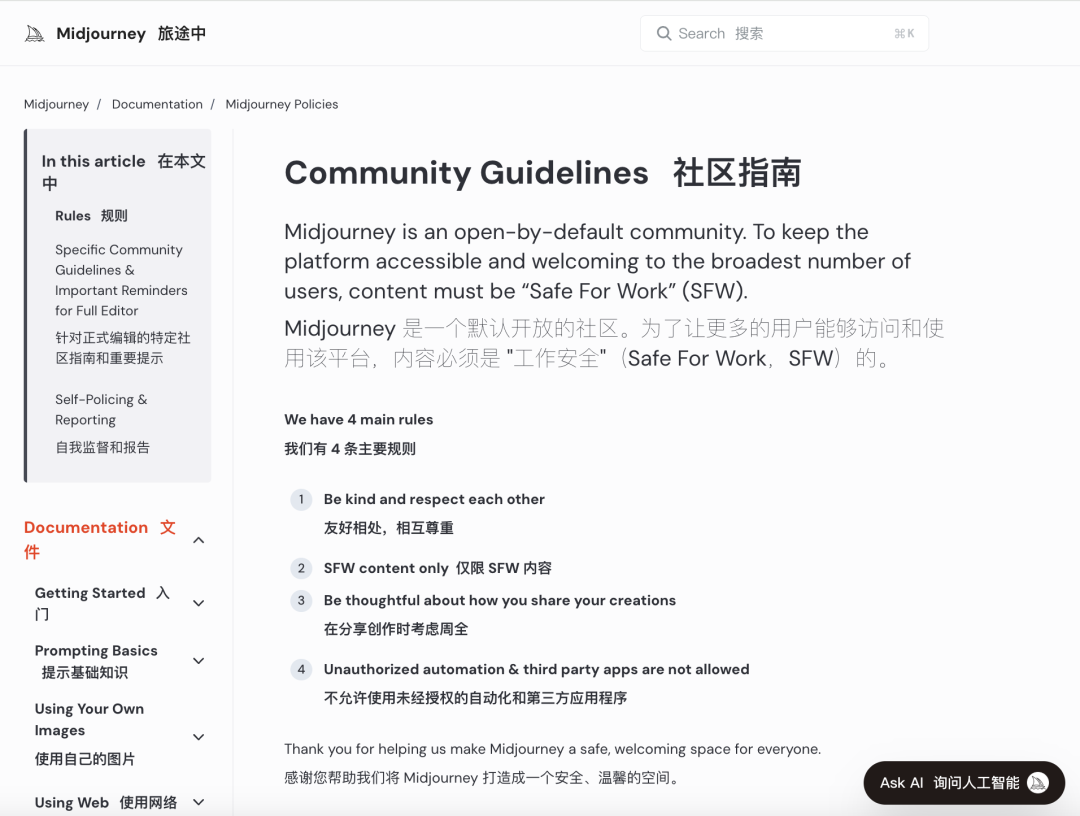

Grandes empresas de IA têm se esforçado para implementar avaliações morais rigorosas para coibir esse uso indevido. Por exemplo, a Midjourney, uma plataforma líder em geração de imagens de IA, possui políticas rígidas contra conteúdo NSFW (Not Safe For Work), incluindo imagens violentas, de nudez ou sexualizadas. Violações podem levar ao banimento da conta. No entanto, essas medidas muitas vezes não são suficientes, pois os usuários encontram maneiras criativas de contornar as restrições, uma prática coloquialmente conhecida como "jailbreaking".

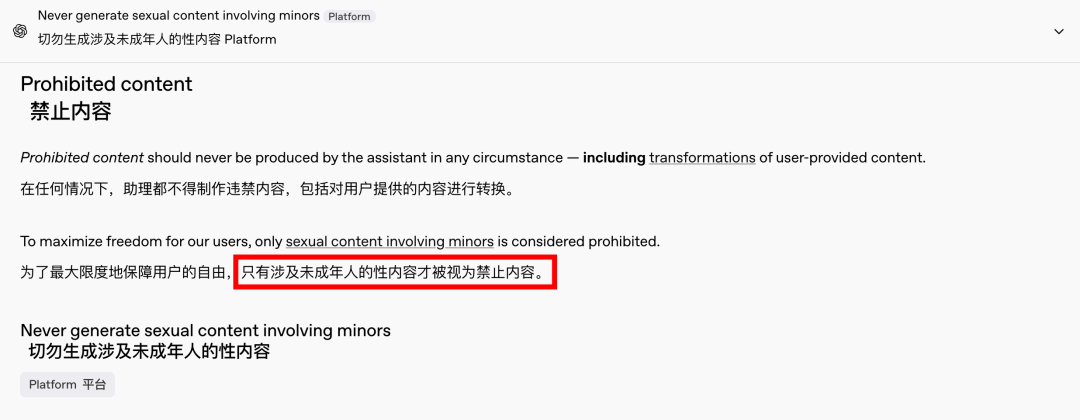

A demanda por conteúdo adulto é um fenômeno global e atemporal, e a IA apenas forneceu uma nova saída. Recentemente, até mesmo a OpenAI flexibilizou algumas de suas restrições de conteúdo devido à pressão do crescimento, exceto para conteúdo envolvendo menores, que permanece estritamente proibido. Essa mudança tornou as interações com a IA mais humanas e envolventes, como evidenciado pelas reações entusiasmadas no Reddit.

As implicações éticas de uma IA sem restrições são profundas

No entanto, as implicações éticas de uma IA sem restrições são profundas. Embora uma IA de espírito livre possa atender a certas demandas dos usuários, ela também abriga um lado obscuro. Sistemas de IA mal alinhados e revisados de forma inadequada podem gerar não apenas conteúdo adulto, mas também discurso de ódio extremo, conflitos étnicos e violência gráfica, incluindo conteúdo envolvendo menores. Essas questões transcendem o âmbito da liberdade e adentram o território das violações legais e morais.

Equilibrar capacidades tecnológicas com considerações éticas é crucial. O relaxamento gradual das restrições de conteúdo pela OpenAI, mantendo uma política de tolerância zero em relação a certos limites, exemplifica esse delicado equilíbrio. Da mesma forma, o DeepSeek, apesar de seu ambiente regulatório rigoroso, vê os usuários encontrando maneiras de ultrapassar limites, o que leva a atualizações contínuas em seus mecanismos de filtragem.

Mesmo Elon Musk, conhecido por seus empreendimentos ousados, dificilmente deixará o Grok 3 sair do controle. Seu objetivo final é a comercialização global e o feedback de dados, não batalhas regulatórias constantes ou protestos públicos. Embora eu não me oponha ao uso de IA para conteúdo adulto, é fundamental estabelecer padrões éticos e de revisão de conteúdo claros, razoáveis e socialmente compatíveis.

Conclusão

Concluindo, embora uma IA totalmente livre possa ser intrigante, ela não é segura. Encontrar um equilíbrio entre inovação tecnológica e responsabilidade ética é essencial para o desenvolvimento sustentável da IA.

Esperemos que eles percorram esse caminho com cuidado.

Cabos de controle

Sistema de Cabeamento Estruturado

Rede e dados, cabo de fibra óptica, patch cord, módulos, painel frontal

16 a 18 de abril de 2024 Middle-East-Energy em Dubai

16 a 18 de abril de 2024 Securika em Moscou

9 de maio de 2024 EVENTO DE LANÇAMENTO DE NOVOS PRODUTOS E TECNOLOGIAS em Xangai

22 a 25 de outubro de 2024 SEGURANÇA CHINA em Pequim

19 a 20 de novembro de 2024 MUNDO CONECTADO KSA

Data de publicação: 20 de fevereiro de 2025