Para BMS, BUS, Industrial, Cabo de Instrumentação.

Manutenção Preditiva de Equipamentos

Implementação Técnica

Caso Relevante

A Schneider Electric implantou essa solução em máquinas de mineração, reduzindo as taxas de falsos positivos em 63% e os custos de manutenção em 41%.

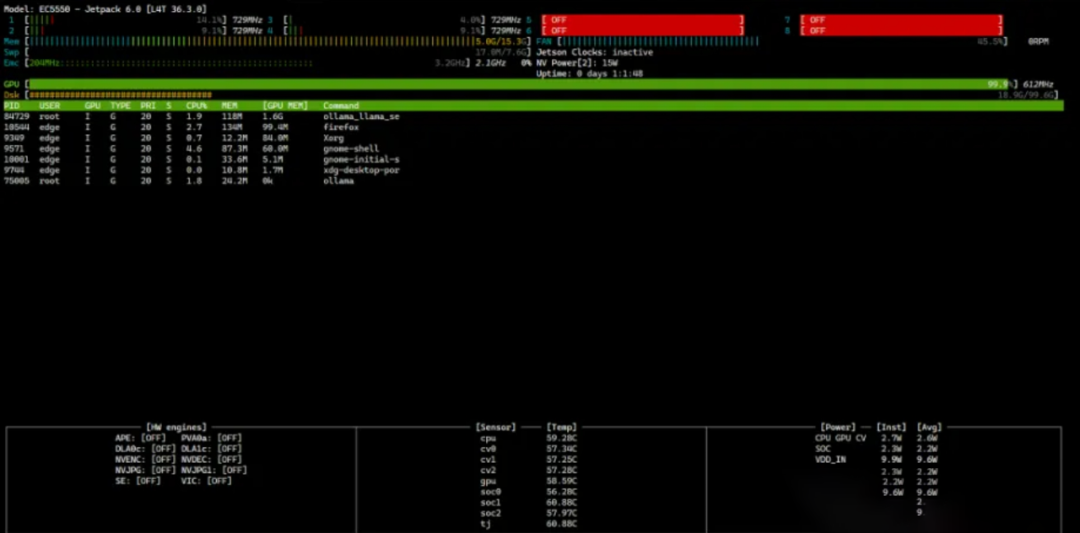

Executando o modelo DeepSeek R1 Distilled em computadores InHand AI Edge

Inspeção Visual Aprimorada

Arquitetura de saída

Métricas de desempenho

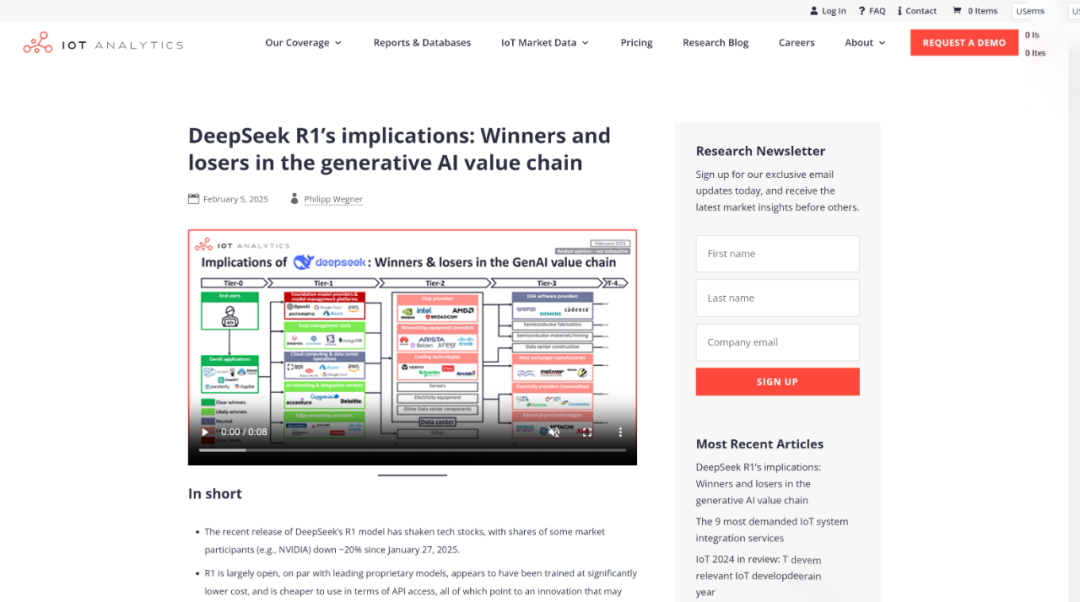

Implicações do DeepSeek R1: vencedores e perdedores na cadeia de valor da IA generativa

Otimização do Fluxo de Processo

Tecnologias-chave

Efeito de implementação

A planta química da BASF adotou esse esquema, alcançando uma redução de 17% no consumo de energia e um aumento de 9% na taxa de qualidade do produto.

Edge AI e o Futuro dos Negócios: OpenAI o1 vs. DeepSeek R1 para Saúde, Automotivo e IIoT

Recuperação instantânea da base de conhecimento

Design de Arquitetura

Caso típico

Os engenheiros da Siemens resolveram falhas de inversores por meio de consultas em linguagem natural, reduzindo o tempo médio de processamento em 58%.

Desafios e soluções de implantação

Conclusão

Os custos atuais de implantação caíram para US$ 599/nó (Jetson Orin NX), com aplicações escaláveis em desenvolvimento em setores como manufatura 3C, montagem automotiva e química de energia. A otimização contínua da arquitetura MoE e da tecnologia de quantização deverá permitir que o modelo 70B seja executado em dispositivos de ponta até o final de 2025.

Cabos de controle

Sistema de Cabeamento Estruturado

Rede e dados, cabo de fibra óptica, patch cord, módulos, painel frontal

16 a 18 de abril de 2024 Middle-East-Energy em Dubai

16 a 18 de abril de 2024 Securika em Moscou

9 de maio de 2024 EVENTO DE LANÇAMENTO DE NOVOS PRODUTOS E TECNOLOGIAS em Xangai

22 a 25 de outubro de 2024 SEGURANÇA CHINA em Pequim

19 a 20 de novembro de 2024 MUNDO CONECTADO KSA

Horário da publicação: 07/02/2025